Meta está implementando limitações mais rígidas de mensagens para adolescentes e controles dos pais

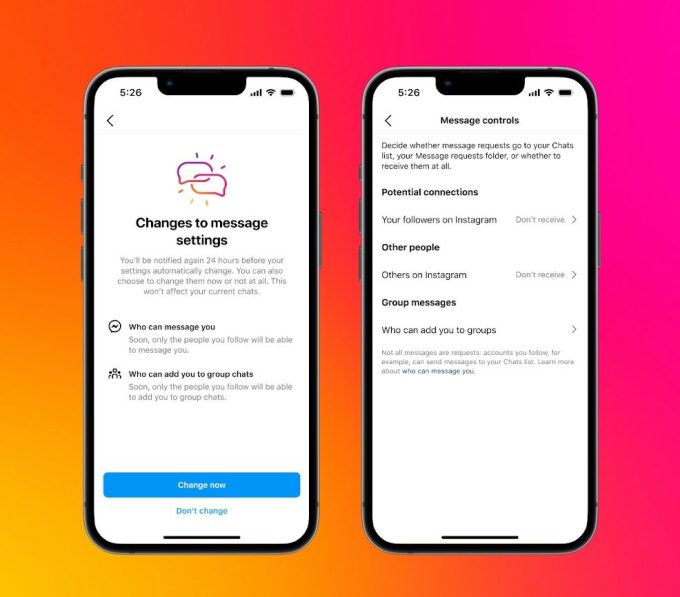

A Meta anunciou hoje que está implementando novas restrições de DM no Facebook e no Instagram para adolescentes que impedem qualquer pessoa de enviar mensagens a adolescentes.

Até agora, o Instagram restringe adultos com mais de 18 anos de enviar mensagens a adolescentes que não os seguem. Os novos limites serão aplicados a todos os usuários menores de 16 anos – e em algumas regiões menores de 18 anos – por padrão. Meta disse que notificará os usuários existentes com uma notificação.

Créditos da imagem: meta

No Messenger, os usuários só receberão mensagens de amigos do Facebook, ou de pessoas que tenham em seus contatos.

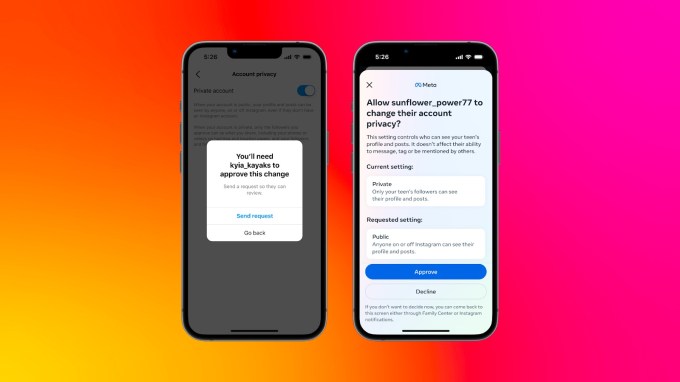

Além do mais, a Meta também está tornando seus controles parentais mais robustos, permitindo que os responsáveis permitam ou neguem alterações nas configurações de privacidade padrão feitas por adolescentes. Anteriormente, quando os adolescentes alteravam essas configurações, os responsáveis recebiam uma notificação, mas não podiam tomar nenhuma ação.

A empresa deu um exemplo de que se um usuário adolescente tentar tornar sua conta pública de privada, alterar o controle de conteúdo confidencial de “Menos” para “Padrão” ou tentar alterar os controles sobre quem pode enviá-los por DM, os responsáveis podem bloqueá-los.

Créditos da imagem: meta

A Meta lançou pela primeira vez ferramentas de supervisão parental para o Instagram em 2022, o que deu aos responsáveis uma noção do uso que seus adolescentes fazem.

A gigante das mídias sociais disse que também planeja lançar um recurso que evitará que os adolescentes vejam imagens indesejadas e inadequadas em seus DMs enviados por pessoas conectadas a eles. A empresa acrescentou que esse recurso também funcionará em bate-papos criptografados de ponta a ponta e “desencorajará” os adolescentes de enviar esse tipo de imagem.

A Meta não especificou que trabalho está fazendo para garantir a privacidade dos adolescentes durante a execução desses recursos. Também não forneceu detalhes sobre o que considera “inadequado”.

No início deste mês, a Meta lançou novas ferramentas para impedir que os adolescentes vejam automutilação ou distúrbios alimentares no Facebook e Instagram.

No mês passado, a Meta recebeu um pedido formal de informações dos reguladores da UE, que solicitaram à empresa que fornecesse mais detalhes sobre os esforços da empresa para prevenir o compartilhamento de material autogerado de abuso sexual infantil (SG-CSAM).

Ao mesmo tempo, a empresa enfrenta uma ação civil no tribunal estadual do Novo México, alegando que a rede social Meta promove conteúdo sexual para usuários adolescentes e promove contas de menores para predadores. Em Outubro, mais de 40 estados dos EUA apresentaram uma acção judicial num tribunal federal da Califórnia, acusando a empresa de conceber produtos de uma forma que prejudicava a saúde mental das crianças.

A empresa deve testemunhar perante o Senado sobre questões relacionadas à segurança infantil em 31 de janeiro deste ano, juntamente com outras redes sociais, incluindo TikTok, Snap, Discord e X (antigo Twitter).